Midjourney, DALL-E, DeepAI: los programas que crean imágenes con inteligencia artificial hacen augurar una avalancha de falsificaciones en las redes sociales. ¿Qué imágenes son reales y cuáles no? Consejos para saberlo.

Nunca ha sido tan fácil crear imágenes engañosamente reales: todo lo que se necesita es una conexión a Internet y una herramienta que funcione con Inteligencia Artificial (IA). En cuestión de segundos, se crean imágenes fotorrealistas que muchos de nosotros percibimos como reales. Y es por eso que se difunden tan rápido en las redes sociales y se suelen usar para desinformar.

Sólo algunos ejemplos recientes que se volvieron virales: el supuesto arresto de Vladimir Putin, el de Donald Trumpo o la imagen de Elon Musk cogido de la mano de Mary Bara, directora ejecutiva de General Motors. Estas imágenes de IA muestran eventos que nunca sucedieron. E incluso hay fotógrafos que publican supuestas fotos de retratos que resultan ser imágenes generadas por IA.

Mientras algunas de estas imágenes pueden resultar divertidas, también pueden suponer un peligro real en términos de desinformación y propaganda, según expertos consultados por DW. El propio Musk pidió junto a cientos de especialistas una pausa en el desarrollo de estas tecnologías.

Terremotos que nunca sucedieron

Eventos como supuestas persecuciones de automóviles espectaculares o arrestos de celebridades como Putin o Trump pueden ser verificados con bastante rapidez por los usuarios que consultan fuentes de medios acreditados. Más problemáticas son las imágenes en las que las personas no son tan conocidas, dice a DW el experto en inteligencia artificial Henry Ajder.

«Y no solo las imágenes generadas de personas pueden difundir desinformación», explica Ajder. «Hemos visto a personas crear eventos que nunca ocurrieron, como terremotos». Como el de la costa pacífica de Canadá y Estados Unidos en 2001, que nunca sucedió: las imágenes compartidas en Reddit fueron generadas por IA.

Cada vez es más difícil clasificar lo que realmente sucedió y lo que no. Pero así como errar es humano, la IA también comete errores, aunque está evolucionando muy rápidamente. Actualmente, programas como Midjourney, Dall-E y DeepAI tienen sus problemas, especialmente con las imágenes que muestran personas. Aquí hay seis consejos del equipo de verificación de hechos de DW sobre cómo detectar la manipulación.

1. Hacer zoom y examinar de cerca

Muchas imágenes generadas por IA parecen reales a primera vista. Los programas utilizados pueden crear imágenes fotorrealistas que a menudo solo pueden revelarse como falsificaciones en una inspección más cercana. Así que el primer consejo es: mira de cerca. Para esto, busque las versiones de la imagen con la mayor resolución posible y haga zoom en los detalles de la imagen. Cualquier incoherencia, error o clonación de imágenes será más fácil de detectar.

2. Encuentre la fuente de la imagen

Intente obtener más información sobre el origen de la imagen que conduzca a su primera publicación. A veces bastan los comentarios de otros usuarios. Una búsqueda inversa de imágenes también puede ayudar: para hacerla, cargue la imagen en herramientas como la de Google, TinEye o Yandex. Si ya hay verificaciones de hechos por parte de medios acreditados en los resultados de los motores de búsqueda, estos generalmente brindan aclaración y contexto.

3. Preste atención a las proporciones del cuerpo

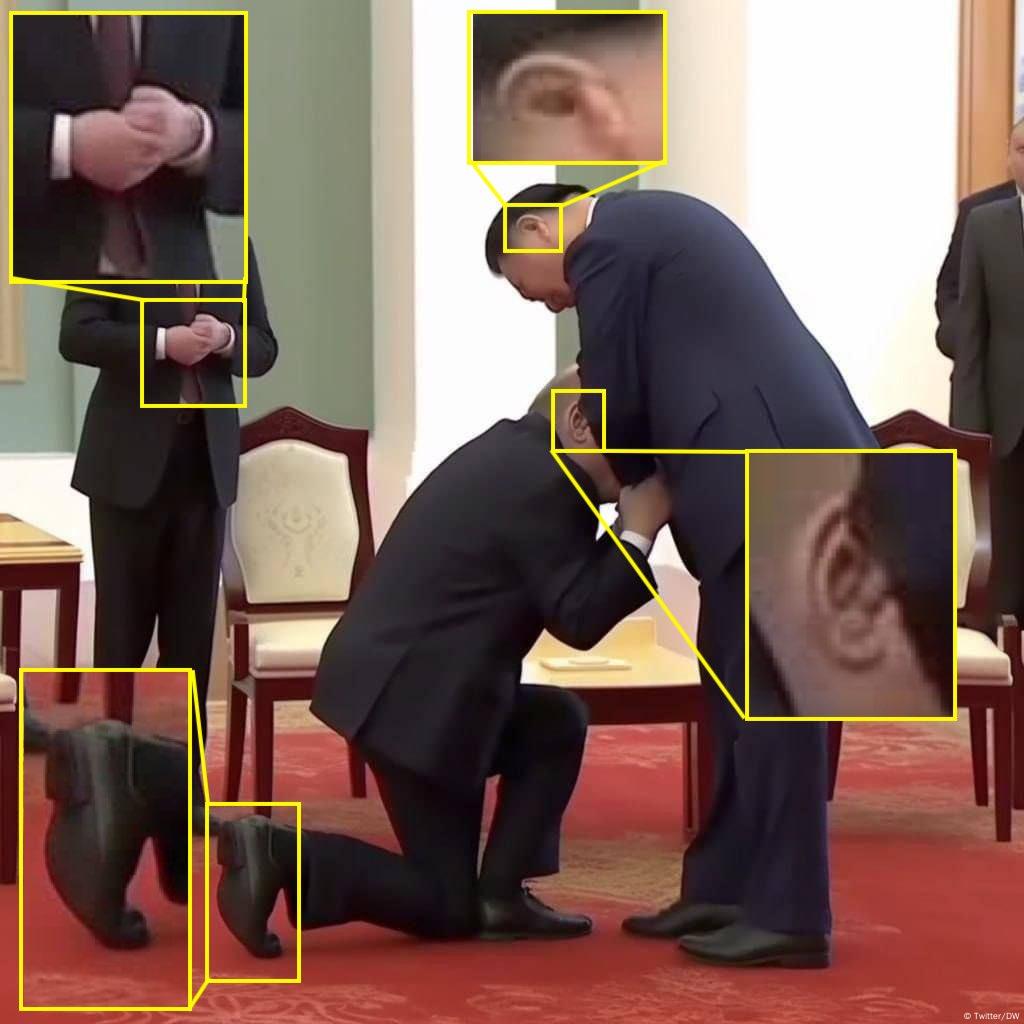

¿Son correctas las medidas de las personas representadas? No es raro que las imágenes generadas por IA tengan inconsistencias en la proporción: las manos pueden ser demasiado pequeñas o los dedos demasiado largos. O la cabeza y los pies no coinciden con el resto del cuerpo. Un ejemplo es la imagen de Putin arrodillado ante Xi Jinping. Su zapato es desproporcionadamente grande, por ejemplo, así como otros detalles.

4. Cuidado con los errores típicos de la IA

Las manos son la principal fuente de errores en los programas como Midjourney o DALL-E. Muchas veces, tienen un sexto dedo, como el policía a la izquierda de Putin en la imagen de nuestro artículo en la parte superior. O les falta alguno, como en las imágenes del papa Francisco posando con ropa de diseño.

Otros errores comunes en las imágenes de IA son los dientes, muchas veces más de la cuenta; las gafas, con marcos extrañamente deformados; o las orejas, que presentan formas poco realistas, como en la mencionada imagen falsa de Xi y Putin. Las superficies reflectantes como las viseras de los cascos también causan problemas a los programas de IA, sus contornos a veces parecen disolverse, como en el caso del supuesto arresto de Putin.

Sin embargo, el experto en IA Henry Ajder advierte: «En la versión actual, Midjourney todavía comete errores como la imagen del papa, pero es mucho mejor para generar manos que las versiones anteriores. La dirección es clara: no podemos seguir confiando mucho más en que los programas van a seguir cometiendo tales errores». Efectivamente, cada vez lo hacen mejor.

5. ¿La imagen parece artificial y suavizada?

La aplicación Midjourney, en particular, crea muchas imágenes que parecen idealizadas, es decir, demasiado buenas para ser verdad. Siga su instinto aquí: ¿puede una imagen ser estéticamente tan perfecta con personas reales? «Los rostros son demasiado puros, los tejidos que se muestran también son demasiado armoniosos», explica Andreas Dengel, director gerente del Centro Alemán de Investigación de IA, en entrevista con DW. La piel de los individuos es a menudo suave y libre de cualquier irregularidad y su cabello y dientes también son impecables.

6. Examine el fondo de la imagen

A veces, el fondo de una imagen delata la manipulación. Los objetos también se pueden mostrar aquí deformados, por ejemplo, las farolas de la calle. En algunos casos, los programas de IA clonan personas y objetos y los usan dos veces. Y no es raro que el fondo de las imágenes de IA esté borroso. Pero incluso ahí puede haber errores. Por ejemplo, cuando el fondo no solo está desenfocado, sino que parece artificialmente borroso, como en esta otra imagen falsa de Will Smith en los Oscar.

Conclusión

Muchas imágenes generadas por IA aún pueden detectarse fácilmente. Pero a medida que la tecnología mejora, es probable que los errores vayan siendo menos habituales. Lo mejor que pueden hacer los usuarios en caso de duda es utilizar el sentido común, confiar en los medios con reputación y evitar compartir las imágenes.

¿Pueden los detectores de IA como Hugging Face ayudar a descubrir la manipulación? Hasta donde sabemos, los detectores proporcionan pistas, pero no más. Los expertos que entrevistamos desaconsejan su uso, ya que las herramientas no están maduras. Las fotos reales también son detectadas como falsas y viceversa.

Las aplicaciones de detección no siempre pueden responder de forma fiable a la pregunta de qué es real y qué no. Hay una «carrera tecnológica» con la inteligencia artificial, dice Antonio Krüger, investigador de IA en la Universidad del Sarre, en entrevista con DW. Y agrega: «Creo que tenemos que acostumbrarnos a que realmente no puedes confiar en ninguna imagen en Internet».

(lgc/dzc)